以计算机视觉、深度学习和大数据为核心,通过创新的技术架构布局多领域、多方向前沿研究,快速打通人工智能场景化应用落地,赋能行业。

通过图像或视频预测心率、心率变异性、血压、血氧、呼吸率压力六大生理指标;实现智能舌诊面诊,分析用户健康状态,赋能智慧医疗等应用场景。

利用对抗训练、活体检测deepfake、异常检测等技术,保证视觉模型不仅精度高并且安全可信,赋能产业安全。

首创类脑神经网络计算模型,该模型具备自适应、可迁移、抗噪声能力。首创多脑区协同脉冲神经网络模型,具备突破多脑区协同视觉、听觉等感知的多模态学习能力,该模型具备自学习、小样本、多模态样本协同学习能力,可以自动标注样本。创新性构建基于脑结构和功能启发的防攻击神经网络模型。

构建了高效的特征比对策略,首先将任务串行化,利用任务的单一性对执行代码进行规划,提升代码的运行效能,具备平移不变性、旋转不变性、尺度不变性,可增强抗干扰,防止数据防篡改。

基于硬件安全模块支持下的可信计算平台,以提高系统整体的安全性,具备高通量编解码、视觉语义分析、视觉图谱构建、视觉任务建模、视觉可信推理。

云服务能力下沉,继承了云安全、存储、计算、人工智能能力,可部署于不同量级的智能设备和计算节点中,通过定义物模型连接不同协议、不同数据格式的设备,提供安全可靠、低延时、低成本、易扩展、弱依赖的计算服务。

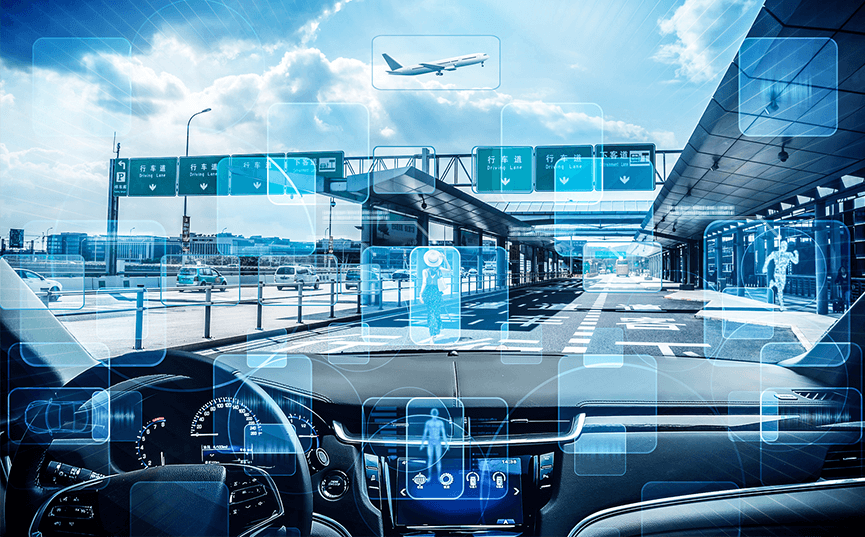

多模态融合感知技术综合利用不同传感器获取的信息,形成了对环境或目标更全面的感知和识别,具备全领域2D/3D视频感知、多方位loT设备感知、全要素数据感知、多维度状态行为感知。

获取的图像进行实时动态分析,并对含有枪支弹药类、爆炸物品类、管制器具类、易燃易爆物品类、毒害性物品类、腐蚀性物品类、放射性物品类、限制携带物品进行实时动态预警和数据推送。

领先的ReID技术,首创突破行人特征表达技术,实现人物跨镜头、跨交通工具、更换服饰的跨场景跟踪。领先的细粒度场景结构化技术、多维度行人结构化技术,基于视觉的任务推理和预测,复杂场景任务管理和规划的智能视觉推理引擎。

利用视频结构化技术及深度学习算法,分析图像/视频中所有的人脸、非机动车、机动车等目标,以及路况、行为等情况,并输出其属性。

人像分析:对图片中行人的衣着、戴眼镜、拎东西、带口罩、帽子、发型、背包、抱小孩等属性的识别分析。

车辆分析:检测图片中的车辆,并对品牌、型号、颜色、车牌号等属性进行识别分析。

场景分析:检测图片中的场景,输出检测出的场景并进行预判分析。

通过预训练的语义角色标注模型引入显式的上下文语义标签信息,以多场景技术应用为导向,提供可直接应用于产品策略的NLP技术能力。

通过对损失函数的有效组合,提高遮挡严重的半身照以及跨域人员的精准度。

通过摄像头实时捕捉用户画面,随机给出动作指令,根据用户做动作的方式;或近红外和深度摄像头捕捉用户画面,判断是否是真人。

利用静脉中红血球吸收特定近红外线的特性,将近红外线照射手指,并由图像传感器感应手指透射过来的光来获取手指内部的静脉图像,进而进行生物特征识别。

通过共享底层网络架构加基于注意力机制的多分支高层网络的训练,提高人脸特征在不同光照,遮挡的变量下特征的鲁棒性。图片/视频中的人脸检测,检出率达92.4%,检测速度达30帧/秒,支持最小为20像素的人脸图像。精确定位图片/视频中人脸的256个关键点。